Computación cuántica y fallos

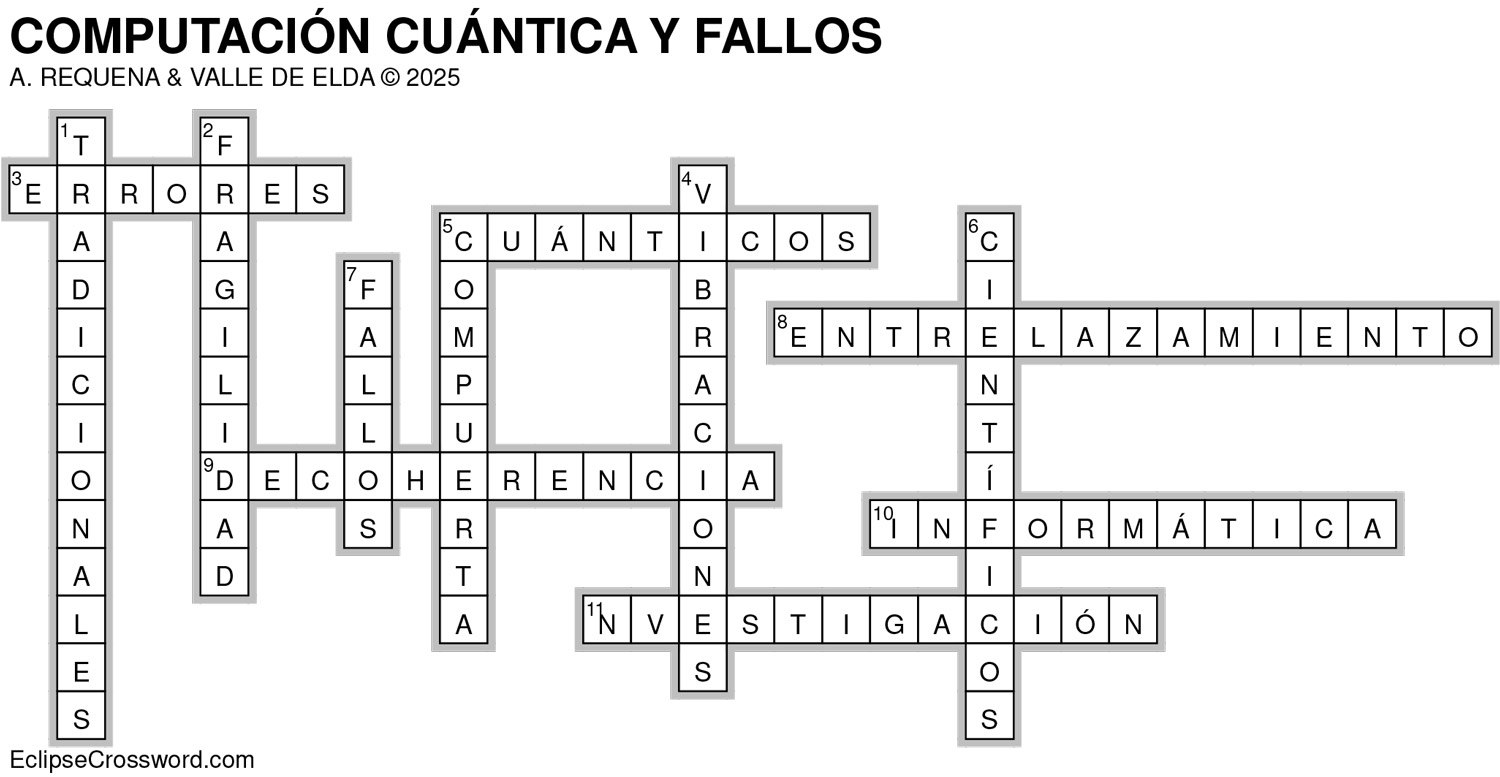

Los ordenadores cuánticos prometen revolucionar la informática al ofrecer una capacidad de procesamiento exponencialmente superior a la de los sistemas clásicos. Sin embargo, en su estado actual de desarrollo, enfrentan numerosos desafíos técnicos que obstaculizan su fiabilidad y escalabilidad. Uno de los principales obstáculos son los fallos cuánticos, es decir, los errores que ocurren durante el procesamiento o almacenamiento de información en los sistemas cuánticos.

A diferencia de los ordenadores tradicionales, que utilizan bits clásicos con estados definidos (0 o 1), los ordenadores cuánticos emplean qubits, que pueden existir en una superposición de estados. Esta característica permite realizar múltiples operaciones simultáneamente, pero también hace que los qubits sean extremadamente sensibles a su entorno. Cualquier pequeña perturbación, como vibraciones, fluctuaciones electromagnéticas o variaciones térmicas, puede provocar una pérdida de coherencia cuántica, lo que genera errores en los cálculos.

Existen dos tipos principales de errores cuánticos: errores de decoherencia y errores de compuerta. La decoherencia ocurre cuando un qubit pierde su estado cuántico debido a la interacción con el ambiente, haciendo que la información almacenada se degrade. Por otro lado, los errores de compuerta se producen cuando las operaciones lógicas sobre los qubits no se ejecutan con la precisión deseada, debido a imperfecciones en el control del sistema o en los materiales utilizados.

Otro aspecto crítico es el entrelazamiento cuántico, fenómeno fundamental para muchas operaciones cuánticas, pero también susceptible a errores. La fragilidad de este entrelazamiento hace que cualquier interferencia externa pueda romperlo, afectando la integridad de los resultados. Por esta razón, incluso las tareas más básicas en una computadora cuántica requieren una gestión meticulosa de las condiciones físicas.

Para contrarrestar estos fallos, los científicos han desarrollado técnicas de corrección de errores cuánticos, que implican codificar la información de un qubit en múltiples qubits físicos. No obstante, estas técnicas requieren elevados recursos: por cada qubit lógico fiable, se necesitan decenas o incluso cientos de qubits físicos. Esto ha limitado el desarrollo de los ordenadores cuánticos de propósito general, ya que todavía no se dispone de suficientes qubits estables para llevar a cabo tareas útiles a gran escala.

El control preciso del hardware, la mejora de la fidelidad de las operaciones y la reducción del ruido ambiental son líneas prioritarias de investigación. Empresas como IBM, Google y startups especializadas como Rigetti o IonQ trabajan intensamente en estos frentes, desarrollando arquitecturas más resistentes y algoritmos tolerantes a fallos.

En conclusión, los fallos en los ordenadores cuánticos son uno de los mayores desafíos para su desarrollo práctico. Aunque se han logrado avances significativos en los últimos años, la fragilidad de los qubits y la complejidad de la corrección de errores siguen siendo obstáculos fundamentales. El camino hacia una computación cuántica robusta y escalable requerirá innovaciones tanto en la física cuántica como en la ingeniería de sistemas. El dominio de estos fallos no solo permitirá el despliegue efectivo de estas máquinas, sino que abrirá una nueva era en la Ciencia, la criptografía y la inteligencia artificial.

Ahora se ha dado un paso significativo para solucionar esta grave cuestión, por parte de los ingenieros del MIT que dien haber logrado un tipo de acoplamiento entre átomos artificiales y fotones que permite lectura y procesamiento de información cuántica. Las consecuencias es que el acoplamiento logrado permite una lectura rápida y realizar operaciones con qubits. La llave de la utilidad de la computación cuántica es la realización de operaciones muy rápidamente, extraordinariamente rápidas. Claro que la lectura, que en realidad es un proceso de medición ahora se propone como un acoplamiento entre fotones y átomos artificiales. Los primeros portan la información cuántica y los segundos almacenan la información.

Los investigadores del MIT han empleado un circuito superconductor donde se dan acoplamientos de haces de luz no lineales que permite alcanzar una rapidez 10 veces superior. Se trata, básicamente de reducir la corrección de errores. Del invento consiste en un nuevo tipo de acoplador cuántico, que facilita las interacciones entre los qubits.

El denominado acoplamiento quarton es un circuito superconductor que lleva a cabo un acoplamiento ni lineal extremadamente fuerte, lo que resulta esencial para ejecutar los algoritmos cuánticos. Cuanto mayor es la corriente de acoplamiento que se suministra, mayor es la interacción cuya intensidad es no lineal. Esto se traduce en que un sistema se comporta por encima de la suma d sus partes y exhibe propiedades más complejas.

La experiencia ha evidenciado, hasta ahora, que las interacciones que resultan útiles en la computación cuántica están asociadas a acoplamientos no lineales de luz y materia. La cuestión actual es que se trata de propiciar acoplamientos que permitan incrementar la fuerza del acoplamiento, lo que implica aumentar la velocidad del procesamiento de la información.

El mecanismo de recuperación de la información, lectura, consiste en aplicar radiación de microondas que se hace incidir en un qubit, y dependiendo del estado en el que está, se cambia la frecuencia de un resonador asociado. Así se mide el cambio y se determina el estado de un qubit. Justamente el acoplamiento no lineal luz-materia es el que facilita el proceso de medición o lectura.

La arquitectura que han diseñado los investigadores del MIT, consiste en un chip que integra un acoplador de quarton conectado a dos qubits superconductores. Uno de los qubits se convierte en un resonador y el otro es un átomo artificia que almacena la información cuántica. La trasferencia de la información se realiza en forma de fotones, concretamente partículas de luz de microondas. Ahora toca incorporar los componentes electrónicos para producir un circuito de lectura a incorporar a un sistema cuántico grande.

La aportación pues, consiste en la propuesta de un procesador cuántico que funciona más rápido, con menor cantidad de error y pueden realizar más operaciones en el mismo tiempo. Es una vía de corrección de fallos, lo cual es esencial para que el cálculo cuántico pueda llegar a ser aplicable a gran escala.

Este blog pretende ser una depresión entre dos vertientes: la ciencia y la tecnología, con forma inclinada y alargada, para que por la vertiente puedan circular las aguas del conocimiento, como si se tratara de un río; o alojarse los hielos de un glaciar de descubrimiento, mientras tiene lugar la puesta a punto de su aplicación para el bienestar humano. Habrá, así, lugar para la historia de la ciencia, las curiosidades científicas y las audacias científico-tecnológicas. Todo un valle.

El eldense Alberto Requena es catedrático emérito de Química de la Universidad de Murcia.

Quizá te interese

0 Comentarios

Lo más leído del mes

Estafa en Elda: un hombre se aprovecha de una mujer con discapacidad y le roba más de 11.000 euros

Denuncian carreras de patinetes en Petrer tras el atropello de un niño en la plaza Unión de Festejos

El CD Eldense hace historia con la creación de su primer equipo femenino absoluto

Elda remodelará una plaza clave en el acceso al casco histórico en la calle Nueva